WebLLM Chat

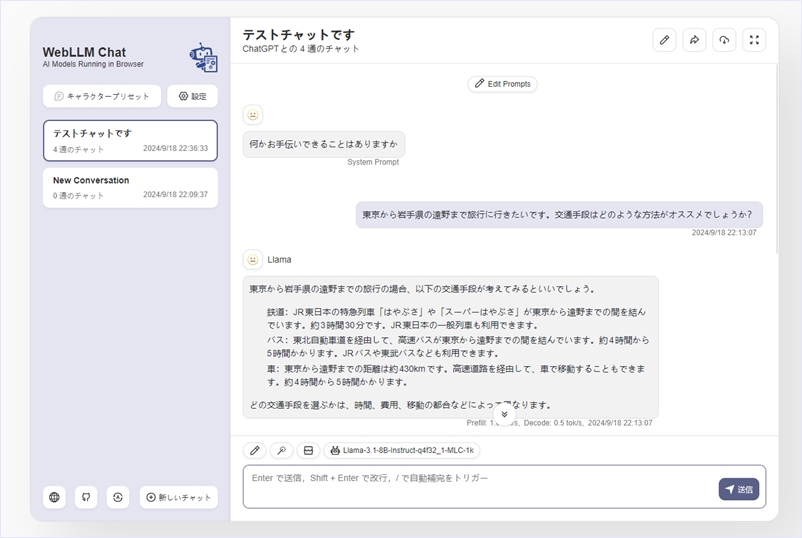

WebLLM Chatはオフラインでも実行できる、ブラウザで動作するオープンソースのAIチャットです。プライベートでサーバーフリーのシームレスなAIチャットを提供してくれる、というもの。

WebGPUアクセラレーションを使用してWebブラウザで任意のLLMを実行可能で、AIモデルはハードウェア上でローカルにて実行され、全てのデータ処理はブラウザで行われるためプライバシーが守られます。そのため、モデルのダウンロードを行った後はオフラインで実行可能となっています。

また、MLC-LLMを介してローカル環境のカスタムLLMにも接続できるのでオリジナルのモデルを使う事も可能です。また、PWAもサポート、多言語化対応で日本語もサポートされています。もちろんマシンスペックに依存するのですが複雑な設定等も不要なのでLLM開発などに貢献してくれるのでは。ライセンスはApache-2.0との事です。